パーソナルコンピュータが登場してからこれまで、コンピュータを使いこなすには、コンピュータの操作方法を覚える、あるいはプログラミングを覚えるなど、人間がコンピュータに合わせる必要がありました。比較的使いやすいと言われているスマートフォンでも、それは同じです。人間が使い方を覚え、使いこなさなければいけないことに変わりはありません。

ところがAmazon EchoやGoogle Nest(旧Google Home)などのスマートスピーカー、あるいはスマートフォンなどに搭載されたSiriのようなAIアシスタントの登場で、その関係性が変わろうとしています。スマートスピーカーやAIアシスタントでは、音声による操作が行われ、コンピュータが人間の言葉や立ち振る舞いに合わせるという前提があります。人間が普段から使っている音声を媒介として操作することで、コンピュータと人間との接し方が大きく変わることになります。

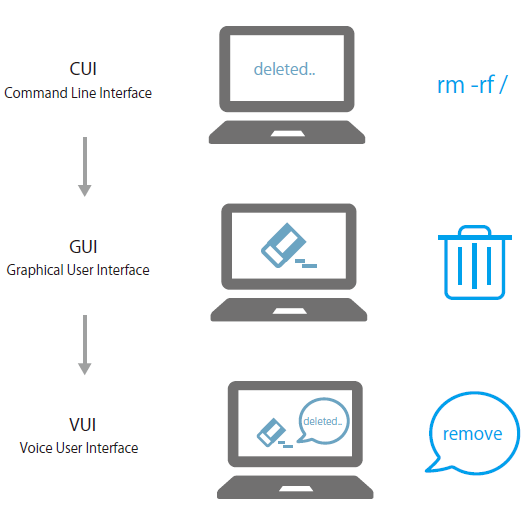

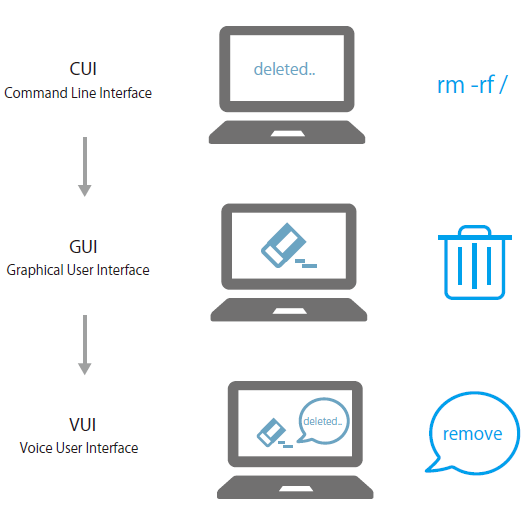

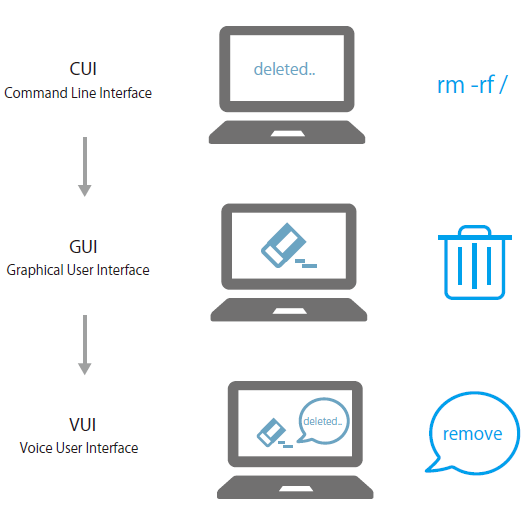

スマートフォンの操作など、現在主流のユーザーインターフェースはGUI(グラフィカルユーザーインターフェース)です。ボタンやメニューを、スマートフォンの場合は指で、パソコンの場合はキーボードとマウスやタッチパッドなどのポインティングデバイスで操作します。

GUIが一般的になる前はCUI(コマンドラインインターフェース)が主流でした。CUIでは、英文字の組み合わせや英単語によるコマンドをキーボードで打ち込んでコンピュータを操作するので、あらかじめコマンドを覚えておく必要がありました。インターフェースとしては、CUIもGUIも、何かを媒介とした間接的な操作となります。

一方、スマートフォンやAIアシスタントはVUI(ボイスユーザーインターフェース)と呼ばれますが、VUIでは操作する内容を直接的に伝えている感覚もありますが、正しく行動してもらえるよう、言葉だけを使って必死でお願いしているという、CUIやGUI以上に間接的な感覚もあります。

重要なこととして、VUIはCUIやGUIの進化の延長線上にあるのではなく、全く違ったタイプのインターフェースということが挙げられます。音声インターフェースを利用したしくみは、スマートスピーカーやスマートフォン搭載というだけでなく、自動車や家電など、これからも増えていくことが予想されますが、そうしたデバイスで動くアプリケーションの作り方もVUIが増えるにしたがって、大きく変わる必要があります。

CUI、GUI、VUIの違い。それぞれ「削除」という操作をしている例

『音声UX ~ことばをデザインするための111の法則』では、こうした音声によるインターフェースを使ったアプリケーション、サービスを作るうえで知っておきたいこと、考え方を111の節でわかりやすくご紹介します。